El alcance de la inteligencia artificial todavía está en pleno desarrollo. Lo que sí puedo contarte hoy es sobre las increíbles posibilidades que ya tenemos al alcance. Y esto no tiene freno.

Seguramente conoces el popular ChatGPT. También habrás oído hablar de la tecnología detrás de él, desarrollada por OpenAI.

Los modelos de inteligencia artificial de OpenAI son impresionantes, y hoy quiero hablarte de uno que quizás no sea tan conocido para el público general. Se llama Whisper, una tecnología que permite transcribir audios a texto y también realizar traducciones de audio.

Esta herramienta es increíblemente útil. Es una solución poderosa que puede potenciar de manera significativa nuestras estrategias de contenido.

¿Qué es Whisper?

Whisper es una tecnología desarrollada por OpenAI. Este modelo permite procesar un archivo de audio (en formatos como mp3, mp4, mpeg, mpga, m4a, wav o webm) para transcribirlo o traducirlo.

Por ahora, la traducción solo está disponible al inglés, pero la transcripción de audio funciona de maravilla.

Lo único que necesitamos es cargar el archivo en alguno de los formatos mencionados y enviarlo a OpenAI. Sin embargo, el tamaño máximo del archivo no puede exceder los 25 MB.

¿Cómo conectarnos a Whisper usando Make?

Para utilizar Whisper, debemos realizar llamadas a la API de OpenAI. Por lo tanto, o bien eres programador, o puedes hacerlo, como en este caso, a través de Make.

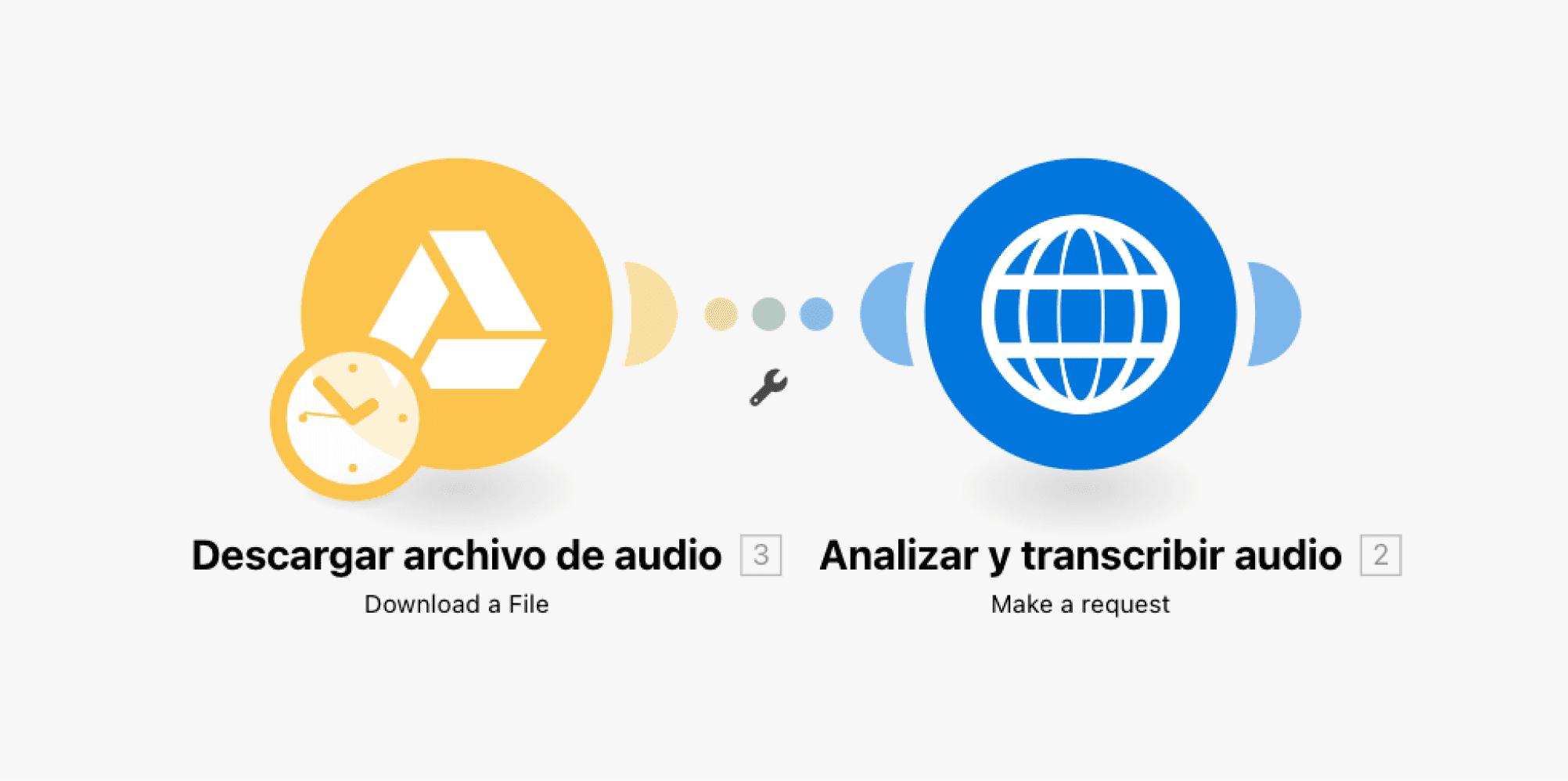

Para configurarlo, necesitamos un escenario como el que aparece en la siguiente imagen.

El primer módulo se encarga de capturar el archivo que queremos enviar a OpenAI para analizarlo. Por ejemplo, podemos extraerlo desde Google Drive si lo tenemos almacenado allí. En el segundo módulo, nos conectamos a la API de OpenAI para convertir ese audio en texto.

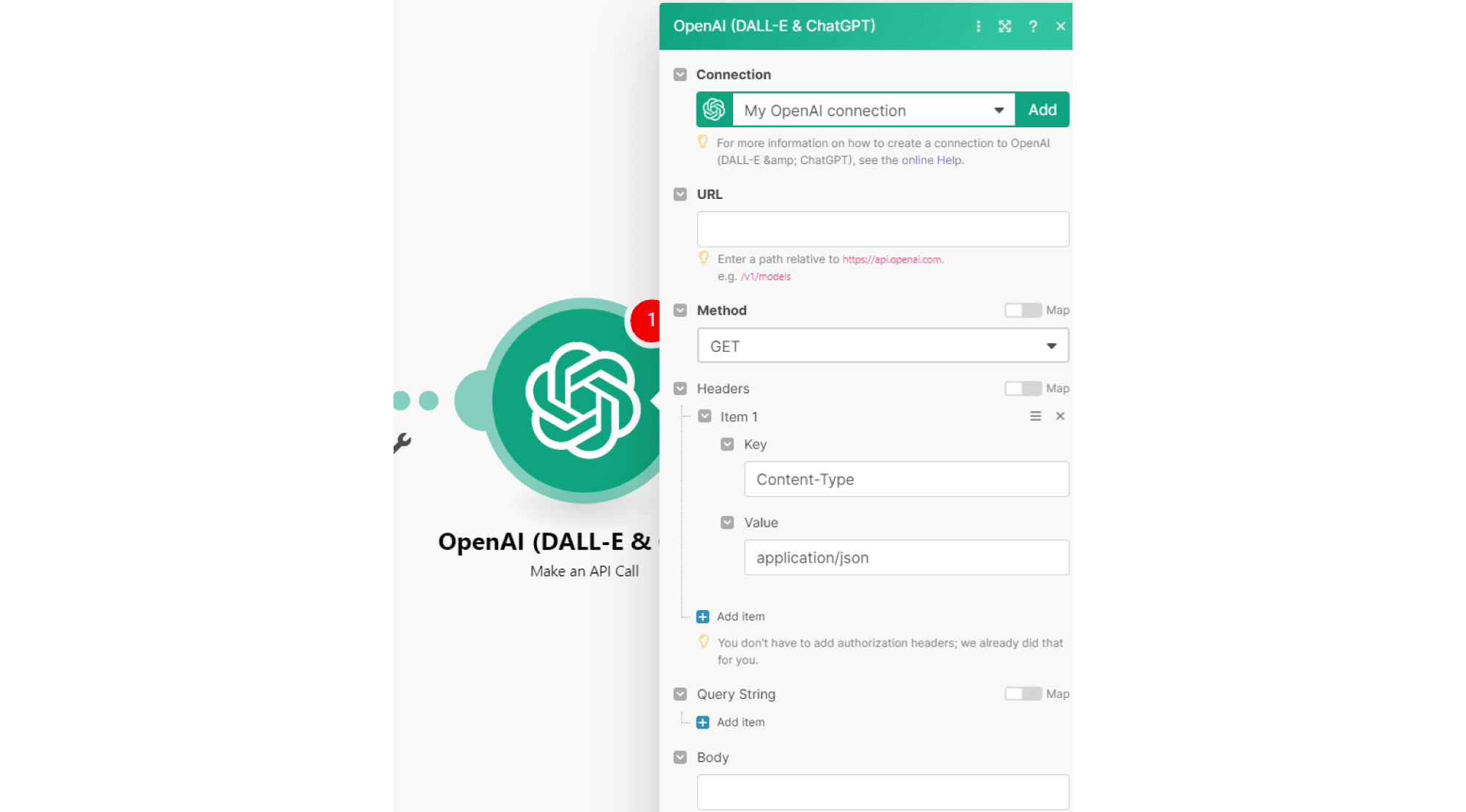

Quizás te preguntes: ¿por qué no utilizar el módulo nativo de OpenAI que ofrece Make? En el momento de escribir este artículo, la integración con Whisper aún no está disponible en las opciones nativas de OpenAI, ni siquiera en el módulo "Make an API call". Esto se debe a que no permite subir el archivo necesario para el análisis.

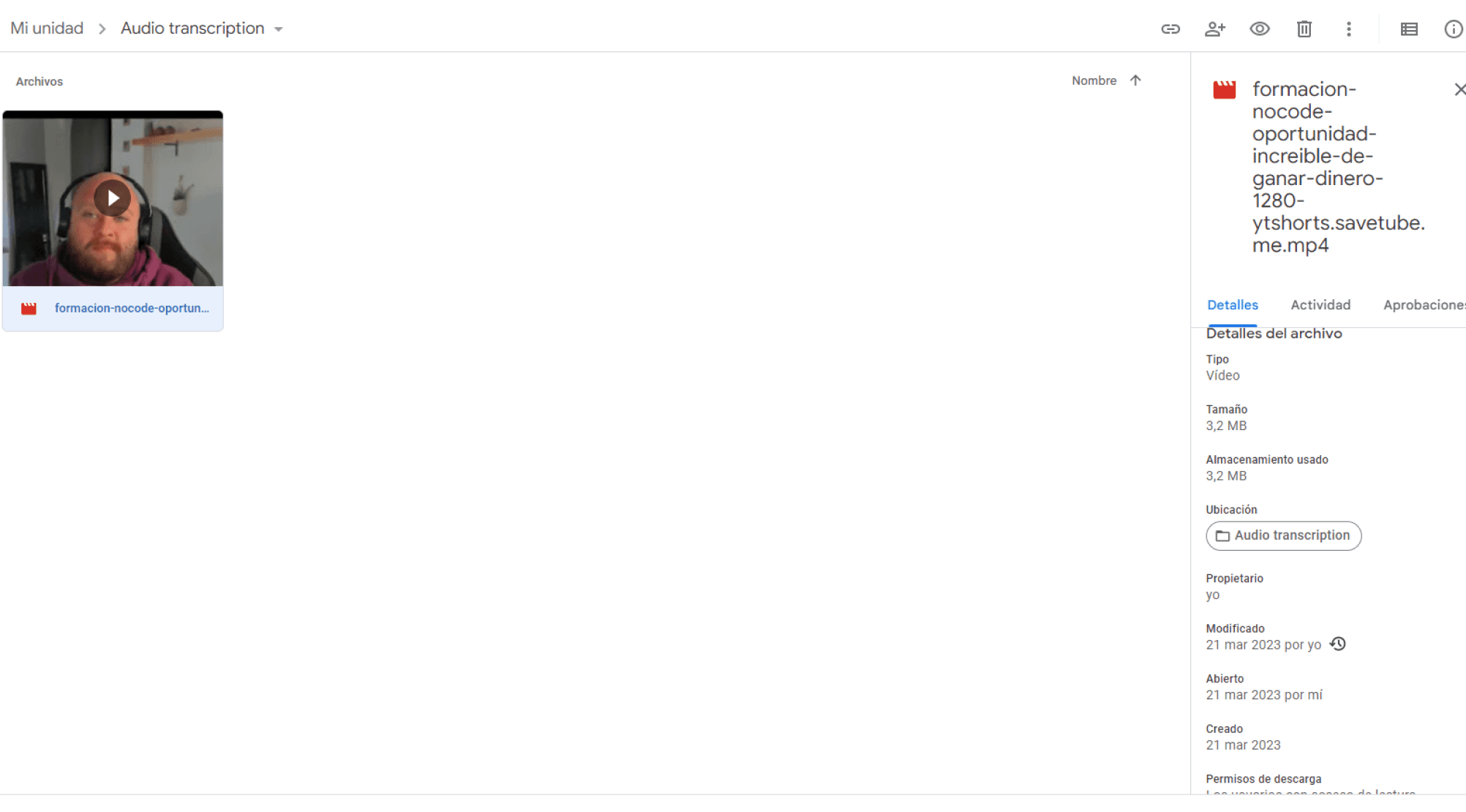

Para comenzar, subimos un archivo de vídeo a nuestra carpeta de Google Drive. Recuerda que no debe superar los 25 MB.

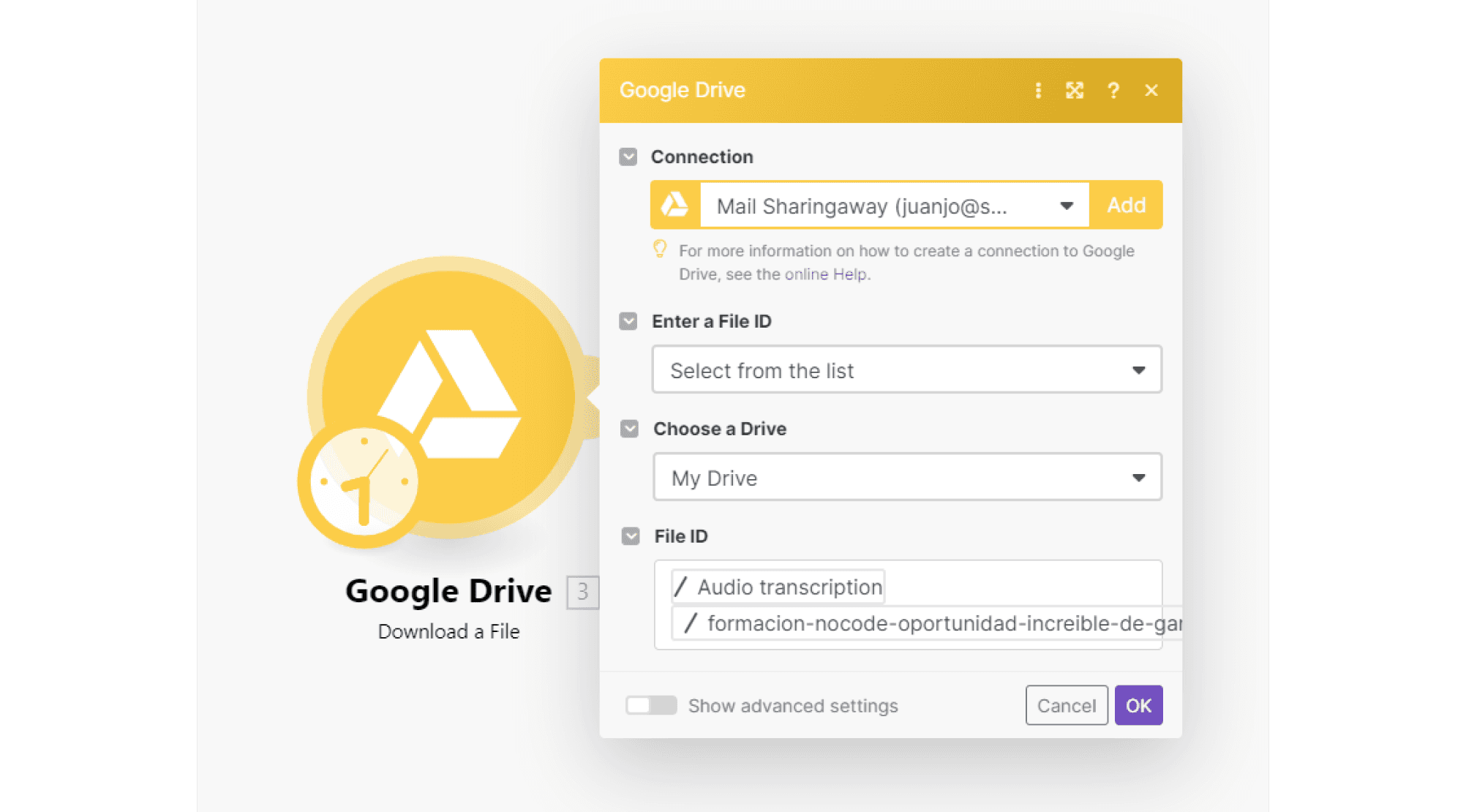

Luego, lo localizamos en Google Drive usando el módulo "Download a File".

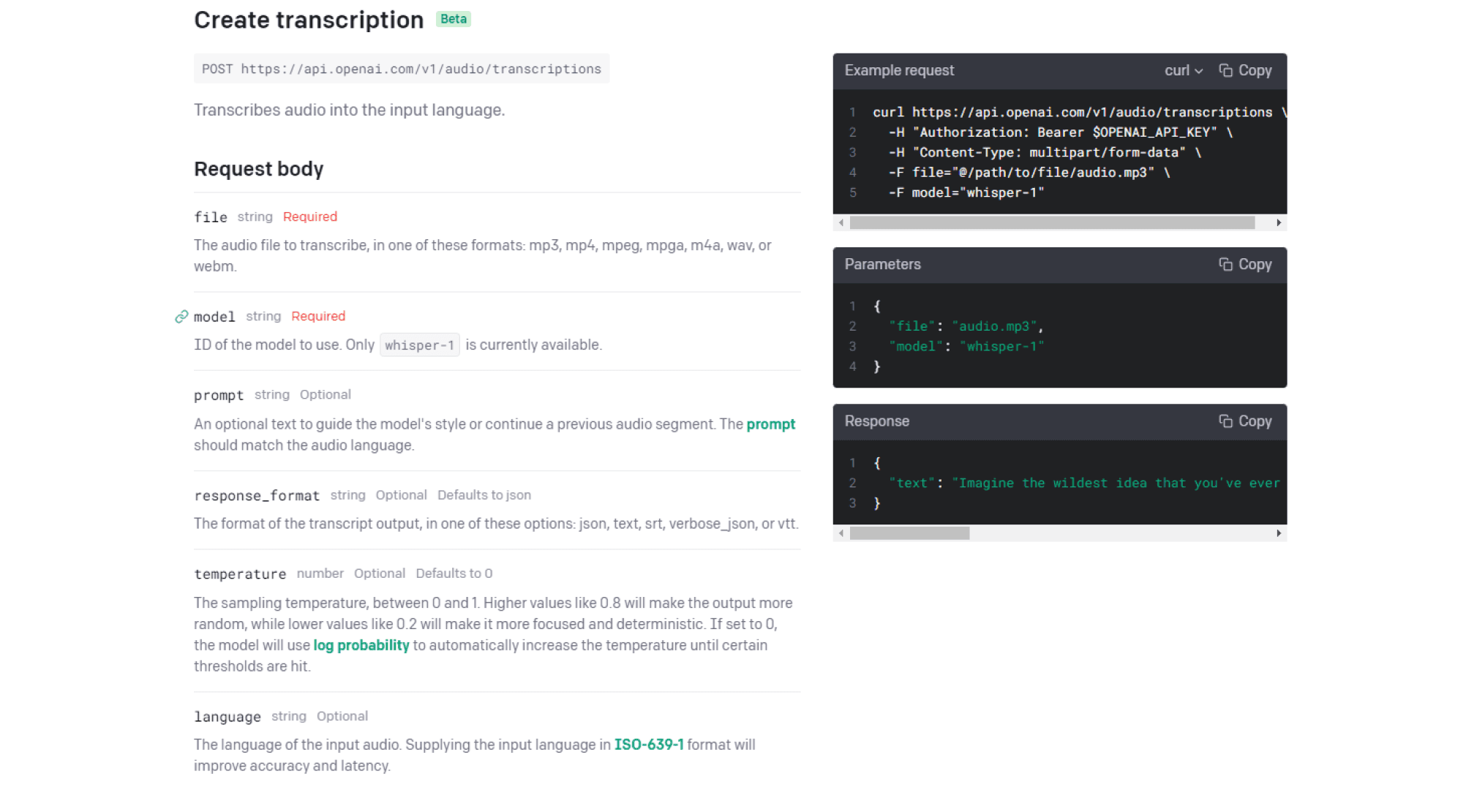

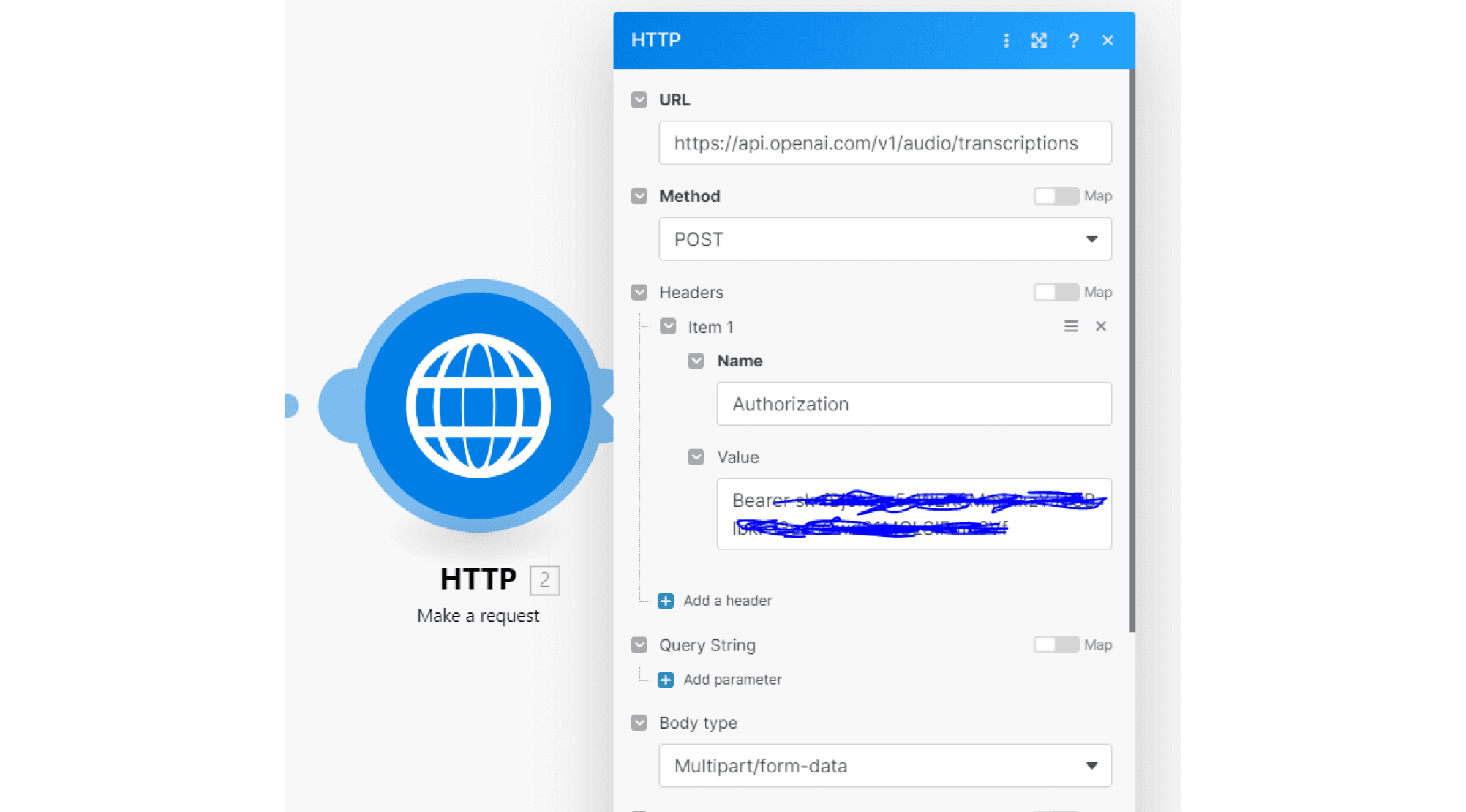

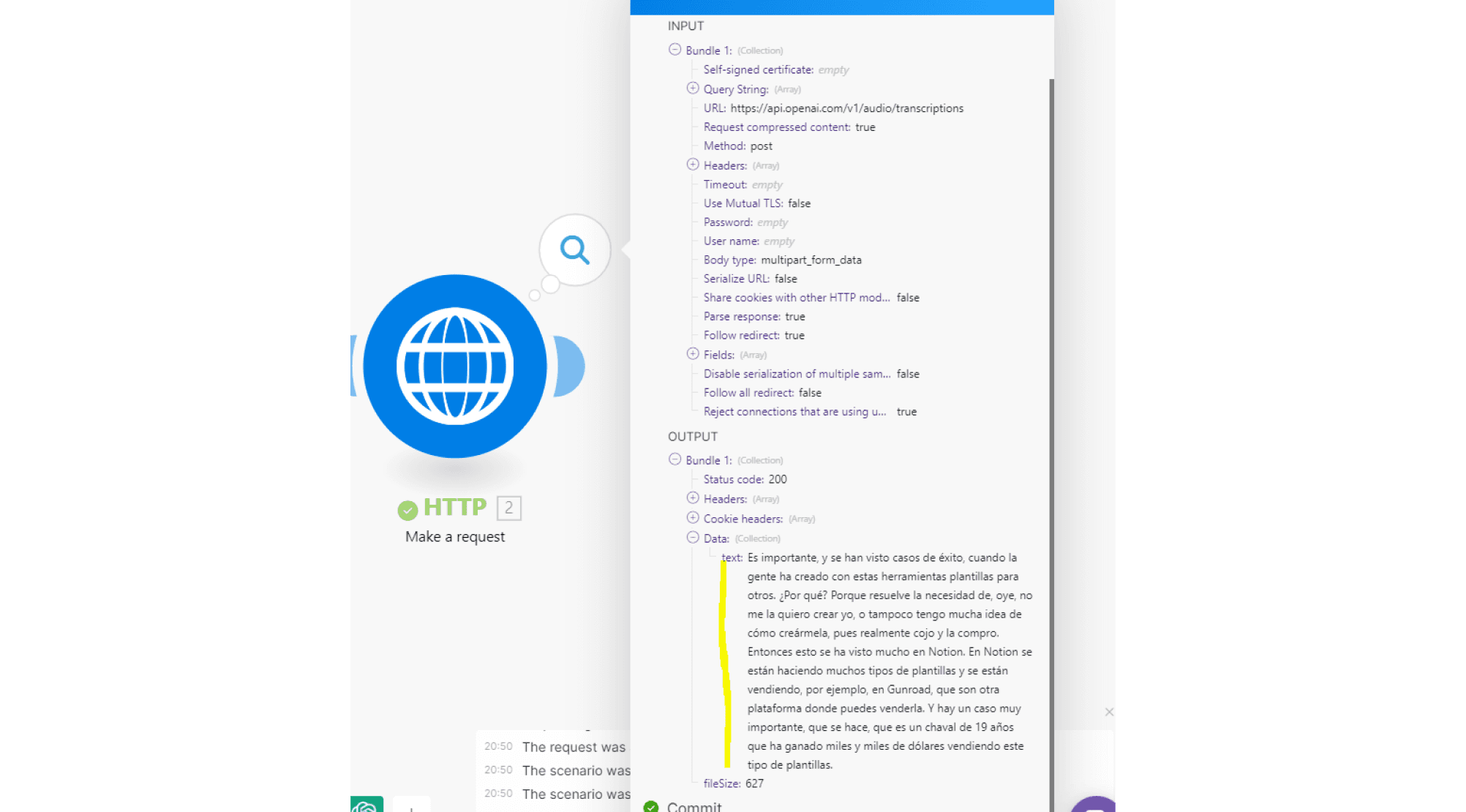

El siguiente paso es añadir un módulo HTTP con "Make a request". Indicamos la URL de la llamada, que puedes encontrar en la documentación de OpenAI (https://platform.openai.com/docs/api-reference/audio).

La URL de la solicitud es https://api.openai.com/v1/audio/transcriptions, y el método de llamada es POST.

En el encabezado, incluimos la autorización necesaria para conectarnos a la API, utilizando el método Bearer seguido de nuestra clave API de OpenAI.

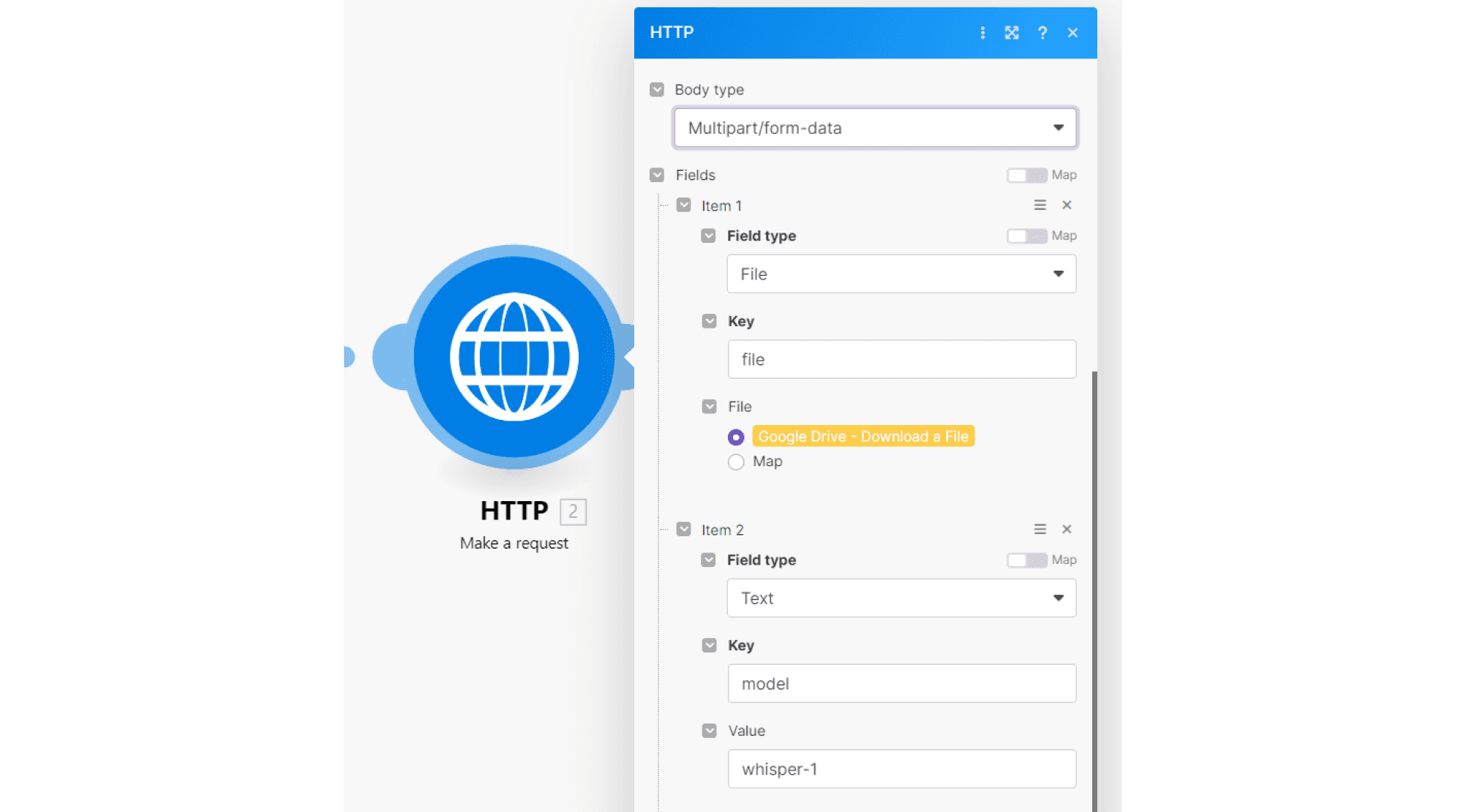

En el cuerpo de la solicitud, seleccionamos el tipo "multipart/form-data". Necesitamos dos campos: el archivo de audio que vamos a analizar (configurado como tipo "File") y el modelo de inteligencia artificial que utilizaremos (de tipo "Text"), en este caso Whisper-1. Así es como se vería:

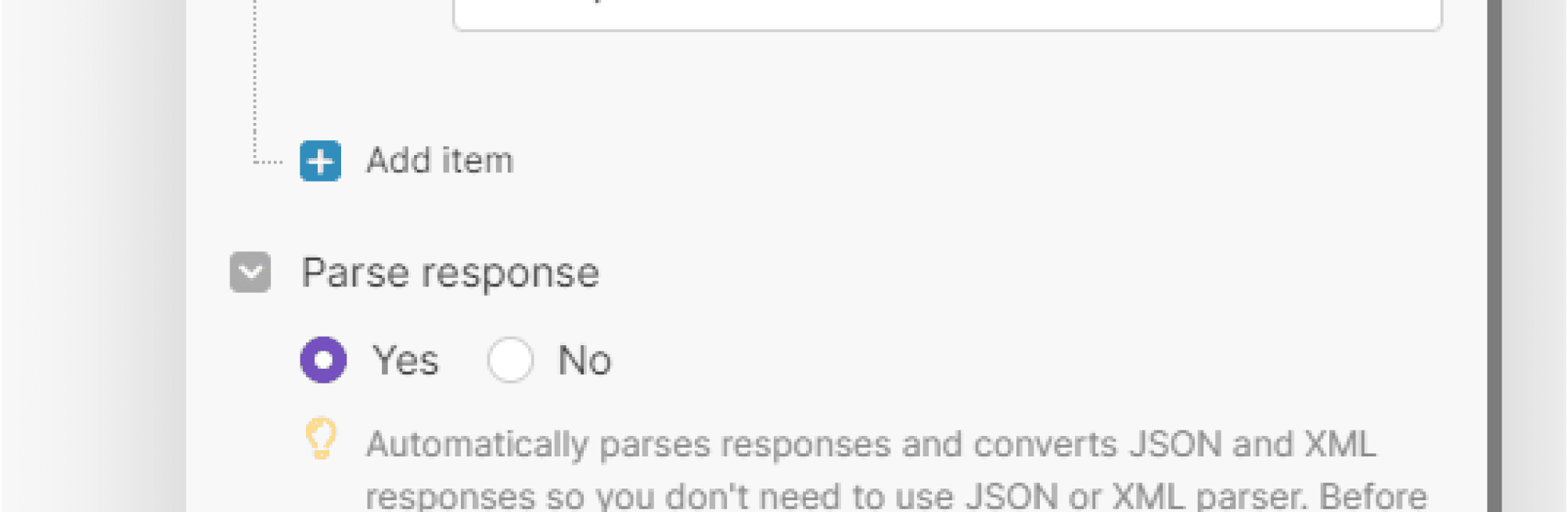

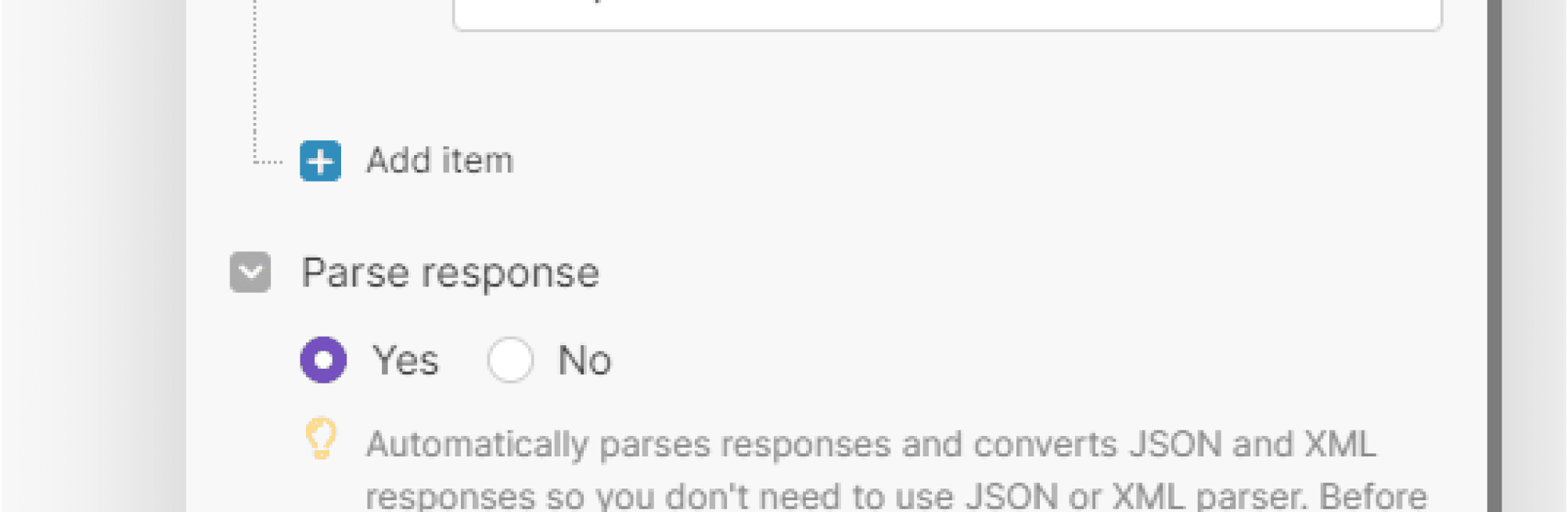

Finalmente, configuramos el módulo para que la respuesta sea procesada automáticamente. Puedes hacerlo en los ajustes inferiores del módulo.

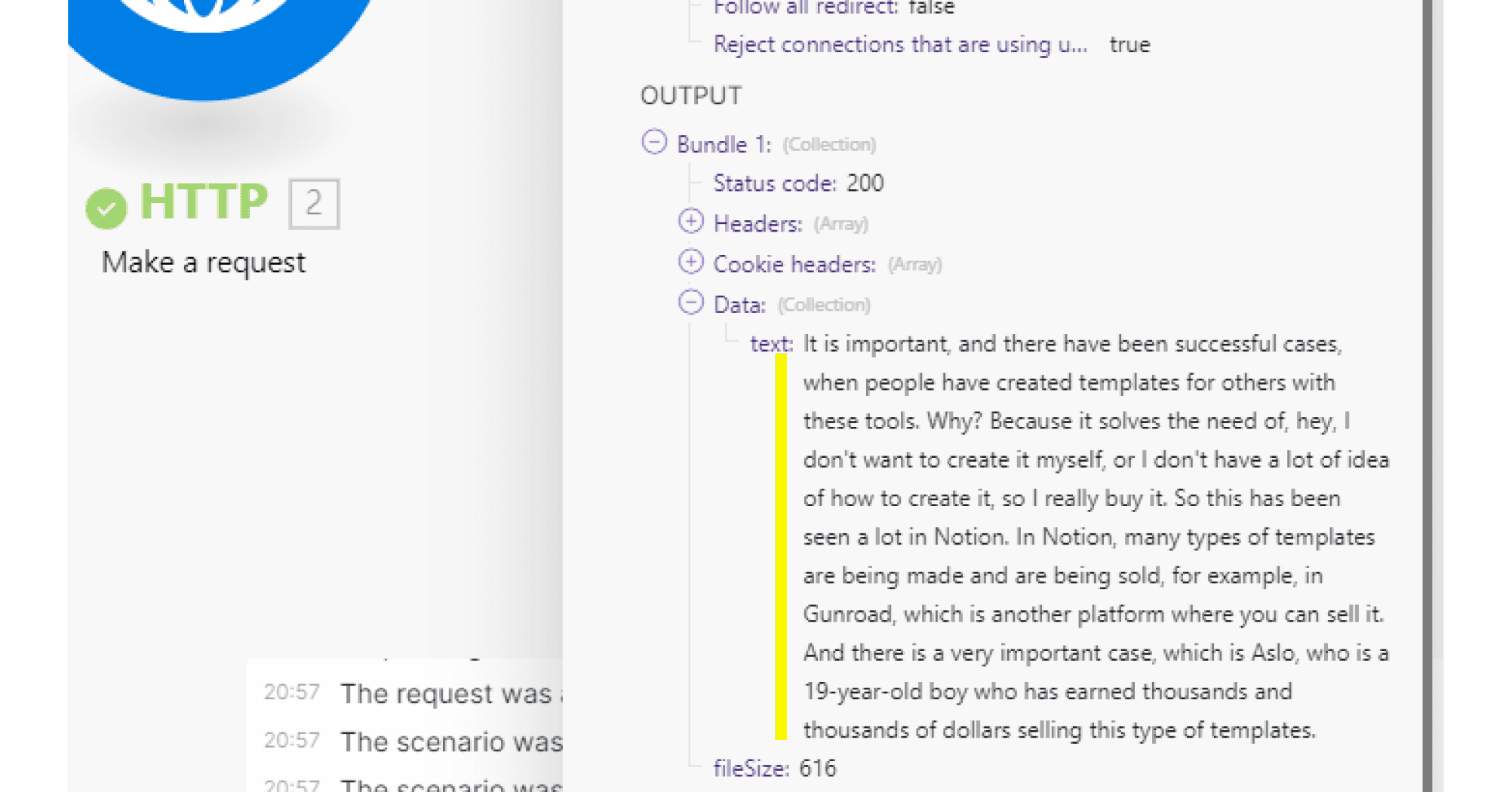

Una vez configurado todo, ejecutamos el escenario y obtenemos la respuesta: audio transcrito.

Podemos ajustar aún más el resultado añadiendo parámetros adicionales, como la temperatura, que controla el nivel de variación en la transcripción.

Traducimos el texto generado al inglés

Con la transcripción en mano, podemos traducirla al inglés. ¿Cómo lo hacemos? Podemos utilizar el modelo Whisper para analizar el audio y realizar la traducción, o recurrir al modelo GPT para traducir directamente el texto obtenido.

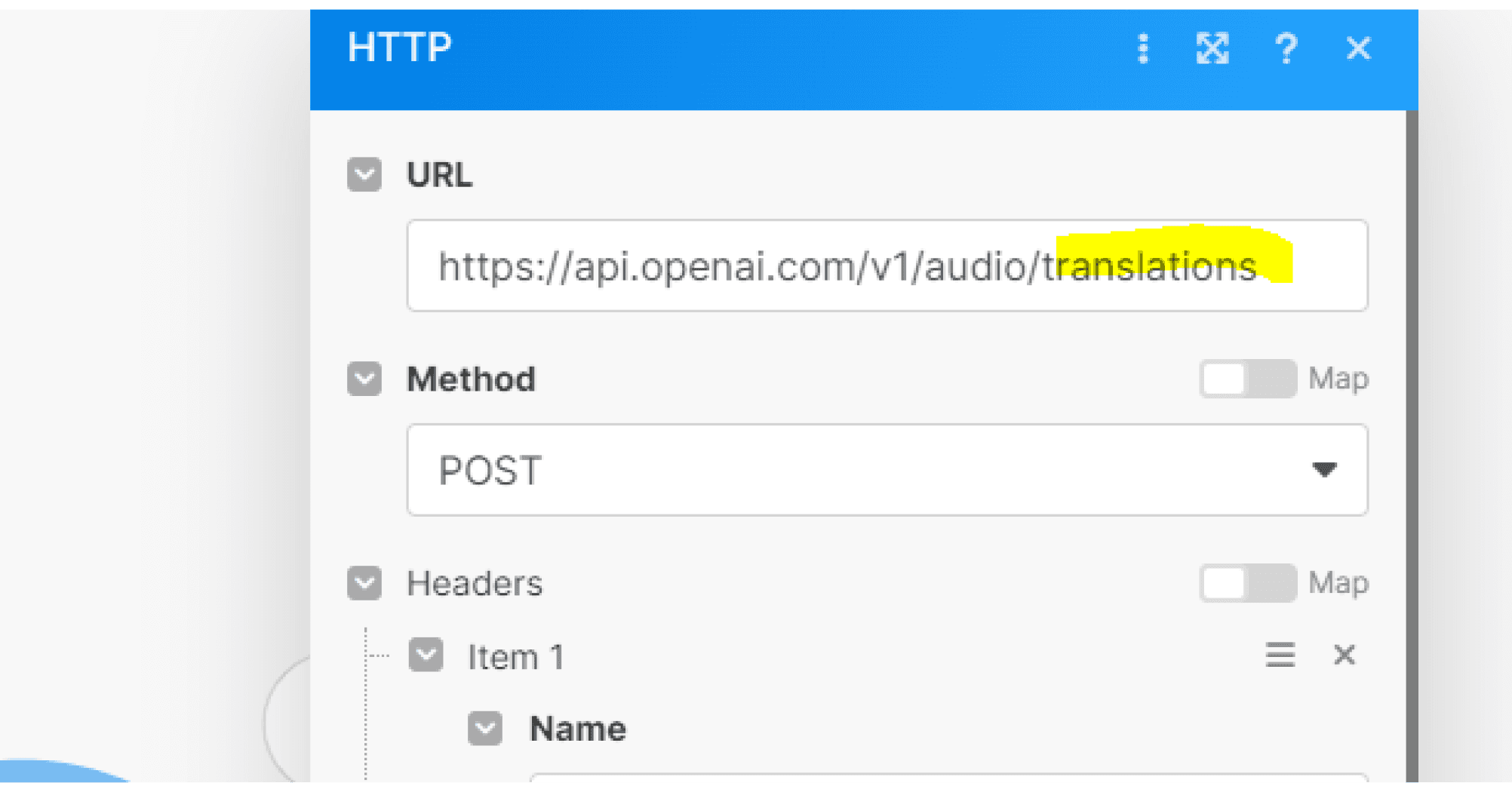

En este caso, vamos a seguir explorando Whisper y cambiar la solicitud a "translations".

Aquí está el resultado:

¿Notas el potencial de esta herramienta y las posibilidades que abre para integrarla en flujos de automatización más complejos?

Para más casos de uso y contenidos relacionados con la IA, visita Buildt Academy. ¡Nos vemos allí!

Post relacionados